- Threads

- 30. Juni 2021

50:50 das die Welt in 200 Jahren untergeht: Warum der IPCC abgeschafft gehört

Expertenurteile finden sich in versch. wissenschaftlichen Disziplinen – insbesondere, wenn Einschätzungen zu Risiken, unter Unsicherheit und/oder anhand limitierter Daten vorgenommen werden müssen.

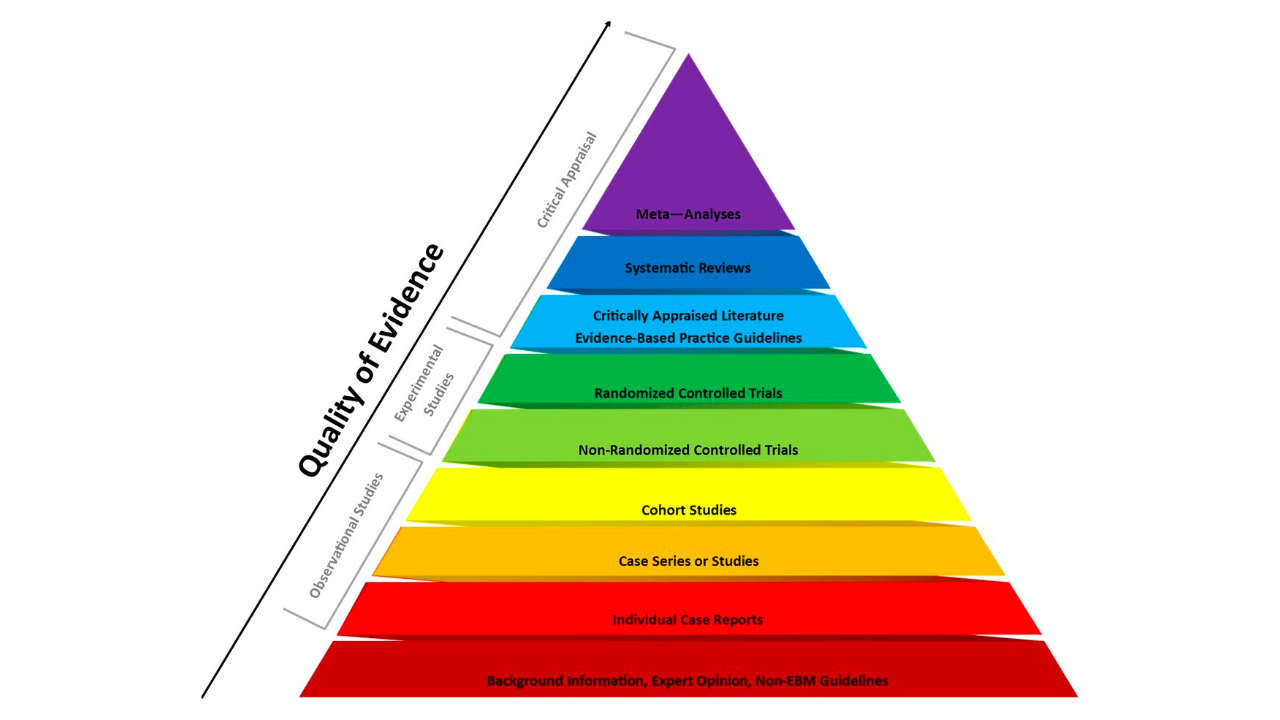

Da Expertenurteile den identischen Urteilsverzerrungen¹ unterliegen wie Laieneinschätzungen, finden sich Expertenmeinungen auf der untersten Stufe der Evidenzpyramide wieder.

Die subjektive Interpretation von Häufigkeits-/Wahrscheinlichkeitsankern ist auch bei Experten einer hohen intersubjektiven Variabilität unterworfen². Die Verwendung ohne quantitative Fundamentierung führt zu bedeutungslosen, da nicht sinnvoll interpretierbaren, Aussagen.³

Aktuelle Standard im wissenschaftlichen Prozess zur Steigerung der Validität von Experteneinschätzungen besteht im Einsatz rigoroser, standardisierter Verfahren, welche den Entscheidungsprozess formalisieren und objektivieren sollen.⁴

Ergänzend werden Rufe nach einer vertieften Einbindung statistischer Expertise bei der Evidenzbeurteilung durch Contentexperten laut.⁵

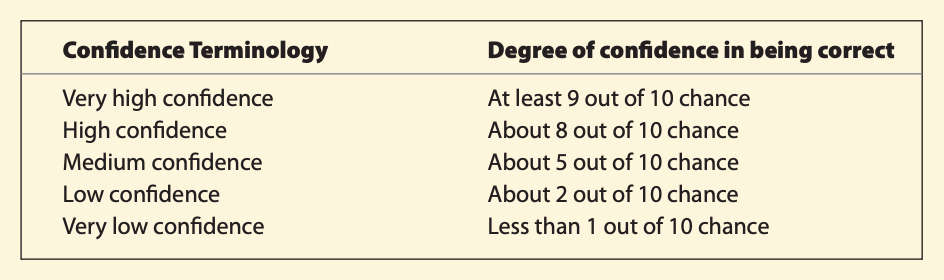

In den Berichten des IPCC, insbesondere in den Executive Summaries für politische Entscheidungsträger, wird das themenspezifische Vertrauen der Autoren in einen wissenschaftlichen Sachverhalt anhand einer normativen 5-stufigen Confidence-Skala ausgedrückt.⁶

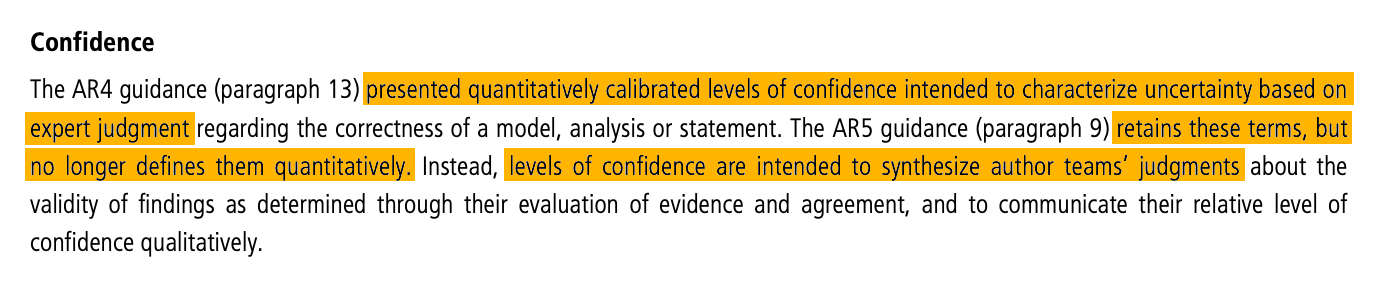

Im AR4 des IPCC wurden die einzelnen Confidence-Stufen „quantitativ kalibriert“ – die Auswahl der passenden Bewertung sollte also anhand einer probabilistischen Abschätzung (z. B. low confidence = ca. in 2 von 10 Fällen) erfolgen.

Mit der Veröffentlichung des AR5 wurde die sogenannte „qualitative Kalibration“ abgeschafft, während die normative Bewertungsterminologie der Confidence Level beibehalten wurde.⁷

Die Probleme an diesem Vorgehen sind:

-

Dem Rezipienten des Berichts wird eine wissenschaftliche Präzision der Befundevidenz vorgegaukelt (medium confidence nach AR4 entspricht aber bspw. lediglich der Wahrscheinlichkeit eines Münzwurfs).

-

Die Entscheidungsfindung der einzelnen Beurteilung ist weder standardisiert, dokumentiert und im Einzelfall transparent publiziert, sondern erfolgt informell – entgegen den Vorgehensvorschlägen der etablierten Forschung (z. B. Granger Morgan, 2014).

-

Aus (2) folgt, dass die Confidence-Abschätzung nicht reproduzierbar ist und sich somit einer wissenschaftlichen Überprüfung entzieht.

Der IPCC gibt Einschätzung zu Sicherheit/Vertrauen in die Validität. Diese erfolgt qualitativ & nicht nach dokumentierten Standards. Empirische Metriken zur Übereinstimmung oder Standardverfahren empirischer Wissenschaften, z.B. Meta-Analysen, werden nicht berichtet.

Erschienen unter: https://twitter.com/MLPoffiziell/status/1421080209676177409

Quellen:

¹ u. a. Tversky, A., & Kahneman, D. (1974). Judgment under Uncertainty: Heuristics and Biases. Science, 185 4157, 1124-31.

² ³ Morgan, M.G., Certainty, uncertainty, and climate change. Climatic Change 108, 707 (2011). https://doi.org/10.1007/s10584

⁴ Granger Morgan, M. (2014). Expert elicitation for decision making. Proceedings of the National Academy of Sciences, 111 (20) 7176-7184; DOI: 10.1073/pnas.1319946111

⁵ Naomi C. Brownstein, Thomas A. Louis, Anthony O’Hagan & Jane Pendergast (2019) The Role of Expert Judgment in Statistical Inference and Evidence-Based Decision-Making, The American Statistician, 73:sup1, 56-68, DOI: 10.1080/00031305.2018.1529623

⁶ „Managing the Risks of Extreme Events and Disasters to Advance Climate Change Adaptation – Special Report of the Intergovernmental Panel on Climate Change“ https://archive.ipcc.ch/pdf/supporting-material/uncertainty-guidance-note.pdf

⁷ https://www.ipcc.ch/.../AR5_Uncertainty_Guidance_Note_Annexes.pdf